- 对象:一个自包含的实体,用一组可识别的特性和行为来标识

- 类:具有相同的属性和功能的对象的抽象的集合

- 实例:一个真实的对象,实例化就是创建对象的过程

- 多态:可对不同类型的对象执行相同的操作,而这些操作就像“被施了魔法”一样能够正常运行

- 封装:对外部隐藏有关对象工作原理的细节

- 继承:可基于通用类创建专用类

多态

- 多态可以让我们在不知道变量指向哪种对象时,也能够对其执行操作,且操作的行为将随对象所属的类型(类)而异。每当不知道对象是什么样就能对其执行操作,都是多态在起作用

- 多态以 继承 和 重写 父类方法 为前提

- 多态是调用方法的技巧,不会影响到类的内部设计

- 多态性即向不同的对象发送同一个消息,不同的对象在接收时会产生不同的行为(即方法)

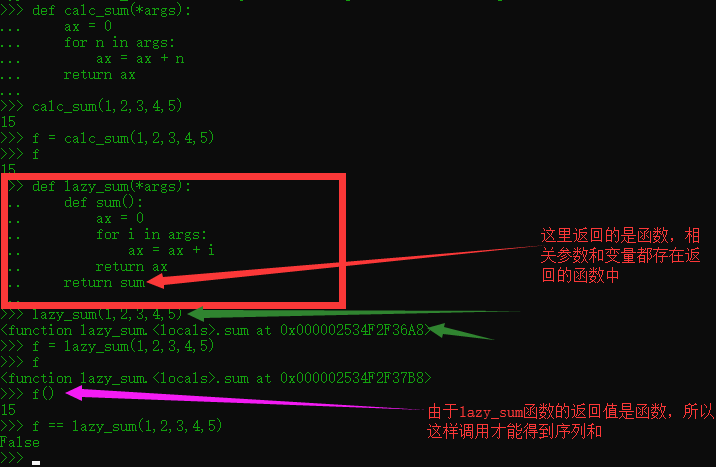

- 听说Python天然就多态

1 | class Person(object): |